CSV Map Connector

Version 24.1.8899

Version 24.1.8899

CSV Map Connector

The CSV Map connector uses ArcScript to transform flat XML files into CSV, TSV, and PSV file formats. A flat XML file is one where, in addition to the root element, the depth is not more than two levels.

Overview

The CSV Map connector has two modes of operation: the visual Designer and the scripting-focused Code view. The Designer enables you to visually establish simple relationships between document types. More complicated translations require the Code view, which leverages the ArcScript scripting language to create a mapping template between XML and a flat file structure.

To begin, from the Settings tab, upload a sample Source File and Destination File. If the structure of both sample files allows for designer-driven mapping, the visual Designer is populated with the source and destination fields. The application also attempts to populate the Code window with as much of the destination structure as it can.

Connector Configuration

This section contains all of the configurable connector properties.

Settings Tab

Connector Configuration

Settings related to the core operation of the connector.

- コネクタId コネクタの静的な一意の識別子。

- コネクタの種類 コネクタ名とその機能の説明が表示されます。

- コネクタの説明 コネクタとフローにおけるロールについて自由形式の説明を記載するオプションのフィールド。

- Source File A file that represents the XML structure of input documents. Any files processed by the connector should have a matching XML structure. To support designer-driven mapping, this file must be a simple XML, CSV, PSV, or TSV structure.

- Destination File A file that represents the structure of output documents. To use designer-driven mapping, this file must be a simple XML, CSV, PSV, or TSV structure.

Mappings

This section defines the mapping relationship between input and output files. The Designer view can map simple XML, CSV, PSV, and TSV structures, and the Code view can map more complicated XML structures. See Using the Designer and Using Code View for details.

Automation Tab

Automation Settings

Settings related to the automatic processing of files by the connector.

- Send Whether messages arriving at the connector are automatically processed.

Performance

コネクタへのリソースの割り当てに関する設定。

- 最大ワーカー数 このコネクタでファイルを処理するためにスレッドプールで消費されるワーカースレッドの最大数。設定された場合、これは設定 > オートメーションページのデフォルト設定をオーバーライドします。

- 最大ファイル数 コネクタに割り当てられた各スレッドが送信するファイルの最大数。設定された場合、これは設定 > オートメーションページのデフォルト設定をオーバーライドします。

アラートタブ

アラートとサービスレベル(SLA)の設定に関連する設定。

コネクタのE メール設定

サービスレベル(SLA)を実行する前に、通知用のE メールアラートを設定する必要があります。アラートを設定をクリックすると、新しいブラウザウィンドウで設定ページが開き、システム全体のアラートを設定することができます。詳しくは、アラートを参照してください。

サービスレベル(SLA)の設定

サービスレベルでは、フロー内のコネクタが送受信すると予想される処理量を設定し、その量が満たされると予想される時間枠を設定できます。CData Arc は、サービスレベルが満たされていない場合にユーザーに警告するE メールを送信し、SLA を At Risk(危険) としてマークします。これは、サービスレベルがすぐに満たされない場合に Violated(違反) としてマークされることを意味します。これにより、ユーザーはサービスレベルが満たされていない理由を特定し、適切な措置を講じることができます。At Risk の期間内にサービスレベルが満たされなかった場合、SLA はViolated としてマークされ、ユーザーに再度通知されます。

サービスレベルを定義するには、予想処理量の条件を追加をクリックします。

- コネクタに個別の送信アクションと受信アクションがある場合は、ラジオボタンを使用してSLA に関連する方向を指定します。

- 検知基準(最小)を、処理が予想されるトランザクションの最小値(量)に設定し、毎フィールドを使用して期間を指定します。

- デフォルトでは、SLA は毎日有効です。これを変更するには、毎日のチェックをOFF にし、希望する曜日のチェックをON にします。

- 期間終了前にステータスを’At Risk’ に設定するタイミングを使用して、SLA がAt Risk としてマークされるようにします。

- デフォルトでは、通知はSLA が違反のステータスになるまで送信されません。これを変更するには、‘At Risk’ 通知を送信のチェックをON にします。

次の例は、月曜日から金曜日まで毎日1000ファイルを受信すると予想されるコネクタに対して構成されたSLA を示しています。1000ファイルが受信されていない場合、期間終了の1時間前にAt Risk 通知が送信されます。

Advanced Tab

Advanced Settings

- 処理の遅延 インプットフォルダに置かれたファイルの処理を遅延させる時間(秒)。これは旧式の設定です。代替として、ローカルファイルシステムの管理にはFile コネクタの使用がベストプラクティスです。

- ローカルファイルスキーム コネクタがアウトプットするメッセージにファイル名を割り当てるスキーム。ファイル名にマクロを動的に使用して、識別子やタイムスタンプなどの情報を含めることができます。詳しくは、マクロ を参照してください。

Message

- Sent フォルダに保存 チェックすると、コネクタで処理されたファイルをコネクタのSent フォルダにコピーします。

- Sent フォルダのスキーム 選択された時間間隔に従ってSent フォルダ内のメッセージをグループ化するようコネクタに指示します。例えば、Weekly オプションを選択すると、コネクタは毎週新しいサブフォルダを作成してその週のすべてのメッセージをそのフォルダに格納します。ブランクに設定すると、コネクタはすべてのメッセージをSent フォルダに直接保存します。多くのメッセージを処理するコネクタの場合、サブフォルダを使用するとメッセージが整理されてパフォーマンスが向上します。

Logging

- Log Level The verbosity of logs generated by the connector. When you request support, set this to Debug.

- Log Subfolder Scheme Instructs the connector to group files in the Logs folder according to the selected interval. For example, the Weekly option instructs the connector to create a new subfolder each week and store all logs for the week in that folder. The blank setting tells the connector to save all logs directly in the Logs folder. For connectors that process many transactions, using subfolders helps keep logs organized and improves performance.

- Log Messages Check this to have the log entry for a processed file include a copy of the file itself. If you disable this, you might not be able to download a copy of the file from the Input or Output tabs.

Miscellaneous

Miscellaneous settings are for specific use cases.

- Other Settings Enables you to configure hidden connector settings in a semicolon-separated list (for example,

setting1=value1;setting2=value2). Normal connector use cases and functionality should not require the use of these settings.

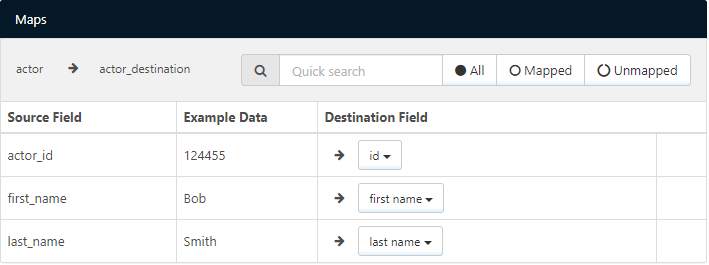

Using the Designer

The visual designer is only available for CSV, PSV, TSV, and simple XML files. Below is an example of a simple XML document as the source file:

<actor table="actor">

<actor_id key="true">124455</actor_id>

<first_name>Bob</first_name>

<last_name>Smith</last_name>

</actor>

This source file might be paired with the following CSV document as the destination file:

id,first name,last name,time

124455,Bob,Smith,2017-07-18T17:38:53-04:00

When these files are configured as the source and destination files, the designer displays rows in the Source Fields column for each row in the source file (actor_id, first_name, and last_name). For each field in the source, use the dropdown to select the appropriate Destination Field column. The application automatically attempts to match the source and destination fields based on the column names. In the above example, the actor_id row would automatically be matched with the id column.

Using the Code View

The Code view provides the ability to generate the mapping template manually using ArcScript. This allows for more granular control over the possible input and output formats. The code view defines how the destination file looks once rendered, with ArcScript elements dynamically filling in the template with values from the source document. ArcScript elements all start with an arc prefix: for example, <arc:set>. Any content in the code view that is not ArcScript is included as part of the output file.

Navigating XML Input

ArcScript supports navigating complicated XML structures to parse out values from the Source File. The xmlDOMSearch operation takes an xpath as input and loads the XML structure at the given path. This operation loops for each instance of the xpath found in the source document: to load the entire document and avoid looping, provide the root element of the XML source as input to xmlDOMSearch. For example:

<arc:call op=xmlDOMSearch?xpath=/root>

<!-- Inside this operation call the parsed XML elements can be accessed -->

</arc:call>

Once the XML document is loaded, the xpath formatter supports reading out values from the XML at the specified xpath. This formatter accepts absolute xpaths as well as xpaths relative to the path loaded by xmlDOMSearch. The xpath formatter, like all formatters, can only be used in square brackets []. For example:

<arc:call op="xmlDOMSearch?xpath=/root/author">

[xpath('name')]

</arc:call>

Take the following simple XML as an example input to the above script:

<root>

<author>

<name>Stephen King</name>

</author>

<author>

<name>Kurt Vonnegut</name>

</author>

</root>

In this example, the xmlDOMSearch operation loops over each author element in the root. Within each author loop, the value from the name element is read as content in the output file. The output file in this case would look like this:

Stephen King

Kurt Vonnegut

Templating Output Data

The Code view serves as a template of the output file, and ArcScript fills in the values to the defined template. As a simple example, if data is formatted as comma-separated values, these commas can be included as part of the Code view to provide structure to the ArcScript functions. Therefore, you can generate more complex CSV files from more complicated XML structures than the Designer mode allows.

For example, take the following XML, which has nested elements that prevent the use of Designer mode:

<actor table="actor">

<actor_id key="true">12445</actor_id>

<name>

<first_name>Viggo</first_name>

<last_name>Mortensen</last_name>

</name>

<actor_id key="true">12522</actor_id>

<name>

<first_name>Gal</first_name>

<last_name>Gadot</last_name>

</name>

</actor>

The nested elements can be retrieved by passing the appropriate paths to ArcScript’s xpath formatter. These formatters can be placed in commas and after header names to provide the desired CSV structure, and an additional csvescape formatter ensures that the values are properly quoted:

id,first name,last name

<arc:call op="xmlDOMSearch?xpath=actor">

[xpath('actor_id') | csvescape],[xpath('name/first_name') | csvescape],[xpath('name/last_name') | csvescape]

</arc:call>

You can generate a wide range of text files with this mix of templating data and ArcScript calls.

Additional Scripting Features

Since full ArcScript is available in Code view, you might want to leverage ArcScript Operations in the template. For example, if the source file only includes the Id of an item in the database, but you need the actual item name, you can use the dbQuery operation to look up the name for the corresponding Id.

ArcScript also supports conditional logic in a mapping template. The arc:if keyword is one of many keywords available to help with performing conditional logic in templates. For example, if the source file contains information about customers in QuickBooks, you might want to perform different business logic for customers with an outstanding balance versus customers who have paid in full. A simple example of this use case might look like the following:

<arc:set item="Customer" attr="paidinfull" value="true" />

<arc:call op="xmlDOMSearch?xpath=Customer">

<arc:if exp="[xpath('balance')] > 0">

<arc:set item="Customer" attr="paidinfull" value="false" />

</arc:if>

</arc:call>

id,first name,last name, paid in full

[xpath('customer_id') | csvescape],[xpath('first_name') | csvescape],[xpath('last_name') | csvescape],[Customer.paidinfull]

Macros

ファイルの命名規則にマクロを使用することで、組織の効率とデータの文脈的理解を高めることができます。マクロをファイル名に組み込むことで、識別子、タイムスタンプ、ヘッダー情報などの関連情報を動的に含めることができ、各ファイルに有益なコンテキストを付与できます。これにより、組織にとって重要な詳細をファイル名に反映させることができます。

CData Arc はこれらのマクロをサポートしており、すべて次の構文を使用します:%Macro%

| Macro | 説明 |

|---|---|

| ConnectorID | コネクタのConnectorID を返します。 |

| Ext | コネクタが処理中のファイルの拡張子を返します。 |

| Filename | コネクタが処理中のファイルのファイル名(拡張子を含む)を返します。 |

| FilenameNoExt | コネクタが処理中のファイルのファイル名(拡張子なし)を返します。 |

| MessageId | コネクタがアウトプットするメッセージのMessageId を返します。 |

| RegexFilename:pattern | コネクタで処理中のファイルのファイル名にRegEx パターンを適用します。 |

| Header:headername | コネクタが処理中のメッセージのヘッダー(headername)の値を返します。 |

| LongDate | システムの現在の日時を長い形式(例:Wednesday, January 24, 2024)で返します。 |

| ShortDate | システムの現在の日時をyyyy-MM-dd 形式(例:2024-01-24)で返します。 |

| DateFormat:format | システムの現在の日時を指定されたフォーマット(format)で返します。使用可能な日付フォーマットについては、サンプル日付フォーマット を参照してください。 |

| Vault:vaultitem | 指定されたvault 項目の値を返します。 |

例

%Ext% や%ShortDate% などの引数を必要としないマクロもありますが、引数を必要とするマクロもあります。引数を渡すマクロはすべて次の構文を用います:%Macro:argument%

以下は、引数を渡すマクロの例です。

- %Header:headername%:

headernameはメッセージのヘッダー名です。 - %Header:mycustomheader% は、インプットメッセージで設定された

mycustomheaderヘッダーの値を返します。 - %Header:ponum% は、インプットメッセージで設定された

ponumヘッダーの値に対応します。 - %RegexFilename:pattern%:

patternは正規表現パターンです。例えば、%RegexFilename:^([\w][A-Za-z]+)%はファイル名の最初の単語と照合し、大文字と小文字を区別せずに結果を返します(test_file.xmlはtestに変換されます)。 - %Vault:vaultitem%:

vaultitemは、vault のアイテム名です。例えば、%Vault:companyname%はVault に保存されているcompanynameアイテムの値を返します。 - %DateFormat:format%:

formatは使用可能な日付フォーマットです(詳細はサンプル日付フォーマット を参照してください)。例えば、%DateFormat:yyyy-MM-dd-HH-mm-ss-fff%はファイルの日付とタイムスタンプを返します。

以下の例に示すように、より詳細なマクロを作成することもできます。

- 複数のマクロを1つのファイル名にまとめる:

%DateFormat:yyyy-MM-dd-HH-mm-ss-fff%%EXT% - マクロの外側にテキストを含める:

MyFile_%DateFormat:yyyy-MM-dd-HH-mm-ss-fff% - マクロ内にテキストを含める:

%DateFormat:'DateProcessed-'yyyy-MM-dd_'TimeProcessed-'HH-mm-ss%